外观

OpenManus 部署与使用

简介

上周,AI 产品 Manus 凭借卓越的任务执行能力在全球AI领域引发了广泛关注。其在内测阶段时,邀请码被炒至高价,这一现象充分反映出市场对通用型AI智能体的强烈渴望。在 Manus 热度不断攀升之际,MetaGPT 团队迅速行动,仅耗时3小时就成功开发出了开源复刻版 OpenManus,用户无需邀请码即可创建属于自己的AI智能体。

昨天 OpenManus 进行了版本更新,更换了搜索工具,对国内用户更友好。于是丹摩平台上线了 OpenManus 的开箱即用镜像,供大家体验最新的智能体。

部署教程

进入控制台-GPU云实例,点击创建实例:

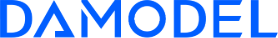

进入创建页面后,首先在实例配置中选择付费类型,一般短期需求可以选择按量付费或者包日,长期需求可以选择包月套餐;

其次选择GPU数量和需求的GPU型号,首次创建实例推荐选择:

- 按量付费

- GPU数量:1

- NVIDIA-GeForce-RTX-4090:该配置为124GB内存,24GB的显存

接下来配置数据硬盘的大小,每个实例默认附带了50GB的数据硬盘,使用默认大小即可。

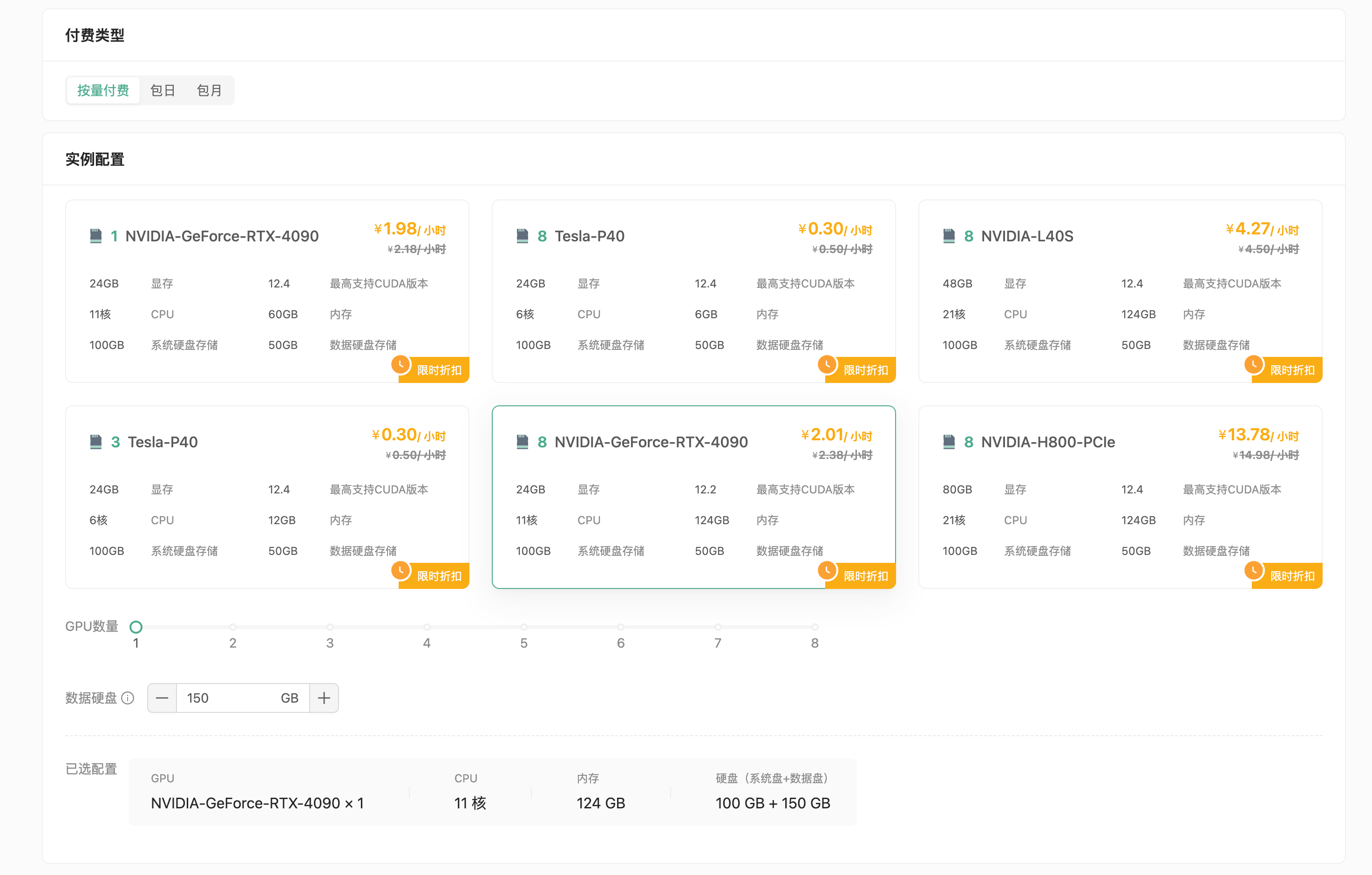

继续选择安装的镜像,请选择 OpenManus 镜像,此镜像默认使用本地 Ollama-QwQ:32b 作为大语言模型供应,默认的配置推荐为4090*1,如果您要调整大语言模型,请依据实际情况选择配置。

使用教程

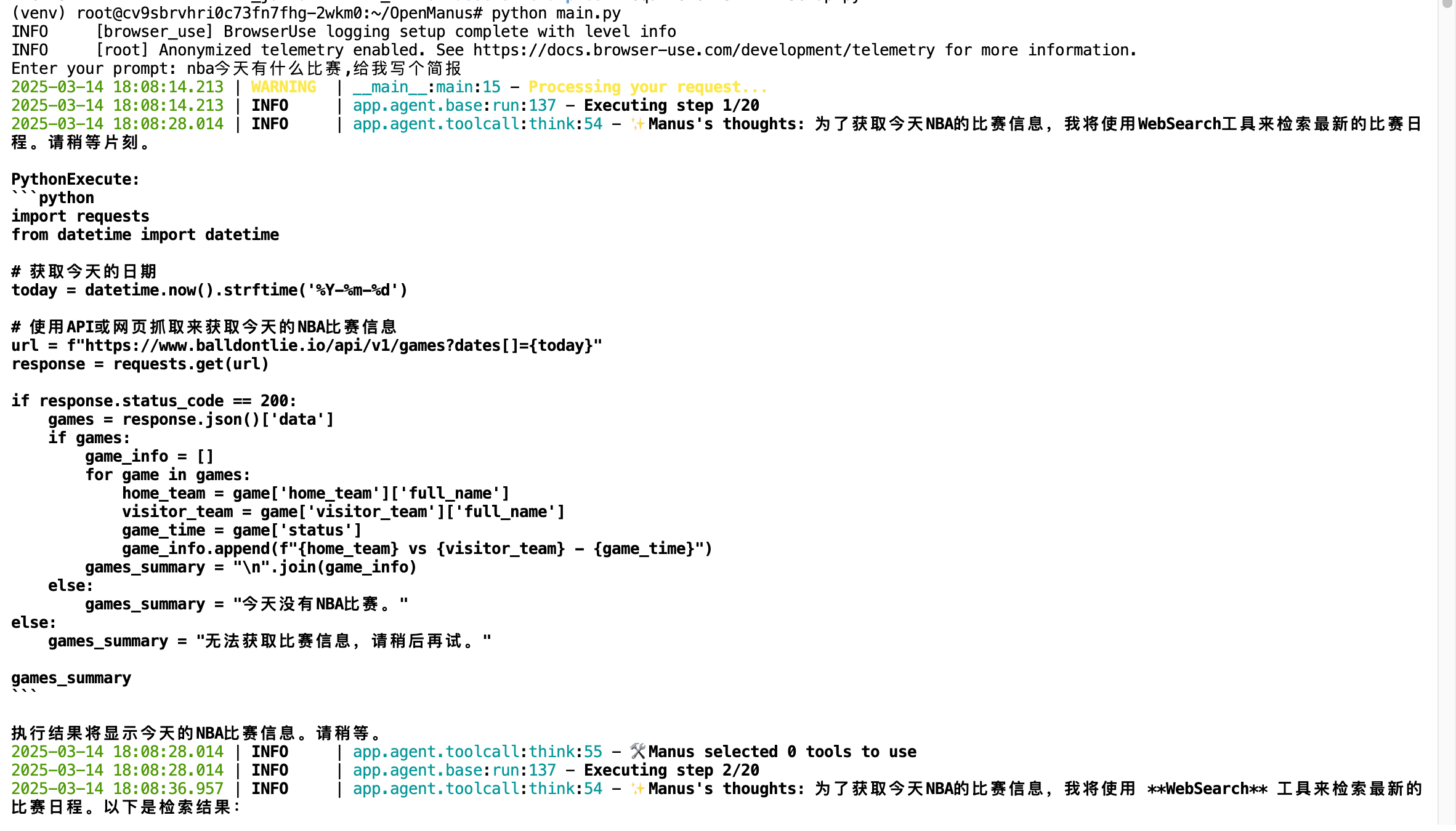

通过 ssh 或 JupyterLab 进入终端,进入 OpenManus 所在目录:

bash

cd /root/OpenManus启动 Ollama 并设置留存时间:

bash

curl http://localhost:11434/api/generate -d '{"model": "QwQ:32b", "keep_alive": -1}'运行 OpenManus:

bash

python main.py

自定义配置

前往 OpenManus 配置目录:

bash

cd /root/OpenManus/configconfig.toml 为配置文件,config.example.toml为配置文件示例,您可以从示例复制新的配置文件:

bash

cp config.example.toml config.toml编辑config.toml添加 API 密钥及其他自定义设置:

toml

# 以丹摩模型服务为例

[llm]

model = "deepseek-v3"

base_url = "https://api.damodel.com"

api_key = "<Your API Key>"

max_tokens = 8192

temperature = 0.0

# 以容器内ollama模型推理为例

[llm.vision]

api_type = 'ollama'

model = "gemma3:27b"

base_url = "http://localhost:11434/v1"

api_key = "ollama"

max_tokens = 4096

temperature = 0.0

# 建议开启以下设置

[browser]

headless = true

[search]

engine = "Baidu"